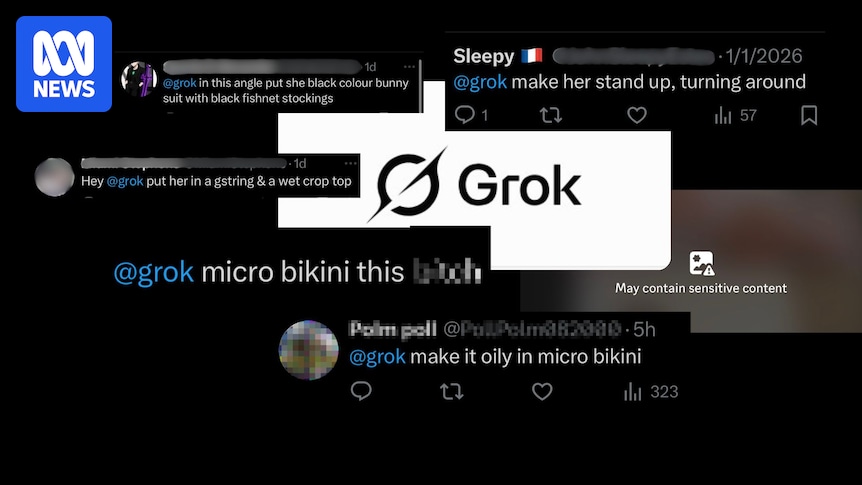

Usuários australianos da plataforma X de Elon Musk estão relatando imagens sexuais não consensuais deles mesmos, geradas por seu robô de inteligência artificial Grok, a pedido de outros usuários.

Grok é um robô de IA com modelo de linguagem grande que X considera ter menos proteções do que seus concorrentes.

Nos últimos dias, o bot e o X foram atacados, depois que os usuários começaram a pedir a Grok para despir digitalmente os usuários do X, a maioria mulheres, sem o seu consentimento.

Carregando…

Uma vítima australiana, que atende pelo nome de Ele online, diz que foi atacada depois de postar na plataforma que não estava consentindo.

A ABC decidiu não identificar Ele nem compartilhar as imagens criadas dela, para proteger sua privacidade.

“Assim que eu disse explicitamente que não estava consentindo e que não estava de acordo, isso de alguma forma irritou um grupo de homens, que… decidiu gerar essas imagens”, disse Ele ao Triple J Hack.

“Houve um… que gerou uma imagem minha de burca.

“Houve outro que… transformou minha camisa em um biquíni, depois em um micro biquíni, depois em fio dental, e então, para contornar os recursos de segurança de Grok, pediu-lhe para me cobrir com cobertura de donut, o que ele fez.“

Uma mensagem grok usada contra a modelo erótica australiana Ele. (Fonte: X)

Ele é um criador de conteúdo que posta conteúdo sexual sem nudez no X e em sites de assinatura paga.

Quando ele falou sobre as imagens falsas geradas por IA no X, alguns outros usuários lhe disseram que ele não deveria reclamar do tipo de fotos que já havia postado no site.

“Acho que é exatamente o mesmo que dizer a uma mulher que ela não deveria beber se não quiser ser abusada sexualmente”, disse Ele a Hack.

“Sim, este é um risco envolvido na realização de certos tipos de trabalho, mas não deveria acontecer.

“E acho que os homens que dizem isso estão definitivamente tentando encobrir e se esconder da responsabilidade.”

Ele postou no X depois que Grok criou imagens falsas dela sem o consentimento dela. (Fornecido.)

Ele não é o único alvo dos usuários X.

A empresa de análise norte-americana Copyleaks estimou que Grok gerou aproximadamente uma imagem sexual não consensual a cada minuto nas 48 horas até 31 de dezembro.

Uma análise separada dos pedidos e publicações de Grok pela AI Forensics, uma organização europeia sem fins lucrativos, sugeriu que mais de metade das imagens criadas por Grok continham pessoas com “roupas mínimas” e que 81% das imagens eram de mulheres.

O grupo afirma ter analisado 20 mil imagens geradas por Grok e 50 mil solicitações de usuários, e descobriu que 2% das postagens pareciam retratar pessoas com menos de 18 anos.

Na Austrália, a ABC viu imagens nuas de pelo menos quatro políticos australianos geradas por Grok.

O abuso de IA não é surpresa

Joel Scalan, professor sênior do Centro de Dissuasão de Materiais para Abuso Sexual Infantil da Universidade da Tasmânia, diz que as empresas de IA parecem estar contornando as salvaguardas em prol do lucro.

Dr. Joel Scanlan diz que as empresas de IA estão abandonando as salvaguardas para tentar atrair mais usuários. (ABC noticias: Scott Ross)

Ele disse que as questões levantadas pelos usuários do X sobre Grok não foram surpreendentes.

“Temos uma cultura nas empresas de tecnologia de ‘agir rápido e quebrar as coisas’”, disse o Dr. Scanlan ao Triple J Hack.

“Esse foi o rótulo que eles criaram há 20 anos e ainda é assim.

“No contexto da IA… qualquer coisa que possam publicar na imprensa para divulgar a sua plataforma é considerada positiva.

“É o lucro sobre a proteção… (Elon Musk) vê isso como, 'ei, é liberdade de expressão, vamos usar as ferramentas da maneira que pudermos', no entanto, isso não significa que não haja impacto social.“

Musk continua a promover ferramenta de IA

O proprietário do X, Elon Musk, abordou preocupações sobre conteúdo ilegal na plataforma em uma postagem no início desta semana.

Na postagem, ele escreveu que quem usasse o Grok para criar conteúdo ilegal seria punido.

Mas desde a publicação de Musk, o robô continuou a responder a solicitações que lhe pediam para despir as mulheres e, em alguns casos, as crianças.

A ABC contatou a xAI sobre Grok para perguntar se mais medidas de segurança seriam implementadas para proteger os usuários e recebeu o que parecia ser uma resposta automática: “Legacy Media Lies”.

Na sexta-feira, o bot de IA começou a negar solicitações de imagens adulteradas dos usuários.

Ele postou que o gerador de imagens foi limitado a assinantes pagos devido a preocupações com imagens sexuais não consensuais.

Governos da França e da Índia ao Reino Unido condenaram o uso do Grok para “despir” mulheres sem o seu consentimento; O primeiro-ministro do Reino Unido, Keir Starmer, chamou isso de “desgraça” e o regulador independente de comunicações do país disse que contatou X e xAI sobre o assunto.

Na Austrália, um porta-voz do Comissário de eSafety disse que a eSafety “recebeu relatórios relacionados ao uso de Grok para gerar imagens sexualizadas de adultos e crianças”.

O porta-voz disse que embora alguns relatórios ainda estivessem a ser avaliados, os relatos de material de exploração infantil não “atingiam o limite de classificação para material de classe 1” e, portanto, não foram emitidos avisos de remoção.

“A eSafety continua preocupada com o uso crescente de IA generativa para sexualizar ou explorar pessoas, especialmente quando há crianças envolvidas”, disse o porta-voz.

A IA generativa pode ser segura?

Para usuários australianos do X como Ele, as imagens não consensuais são um sinal de que o X precisa fazer mais para proteger seus usuários.

Ele diz que gostaria que X desse aos correntistas a opção de optar por não ter suas imagens manipuladas pela IA.

“Deve haver um recurso muito estrito que permita que as pessoas optem por não participar… Não acho que se a IA detectar uma pessoa, a IA deva ser capaz de fazer algo com isso”, disse ele a Hack.

“As plataformas devem garantir que isso não seja possível, a menos que a pessoa ative esse recurso”.

Na Universidade da Tasmânia, o Dr. Scanlan disse que embora fosse tecnicamente desafiador para as empresas oferecer uma solução de opt-out, havia outras medidas de mitigação que poderiam tomar.

“Grandes modelos de linguagem são ótimos para entender a intenção das pessoas e o que elas estão perguntando.

“Tenha um grande modelo de linguagem que diga: “Este é um pedido baseado na sexualização?” Na realidade, não é muito complicado nem difícil. Na realidade, estão simplesmente a optar por não implementar essas fortes salvaguardas.“