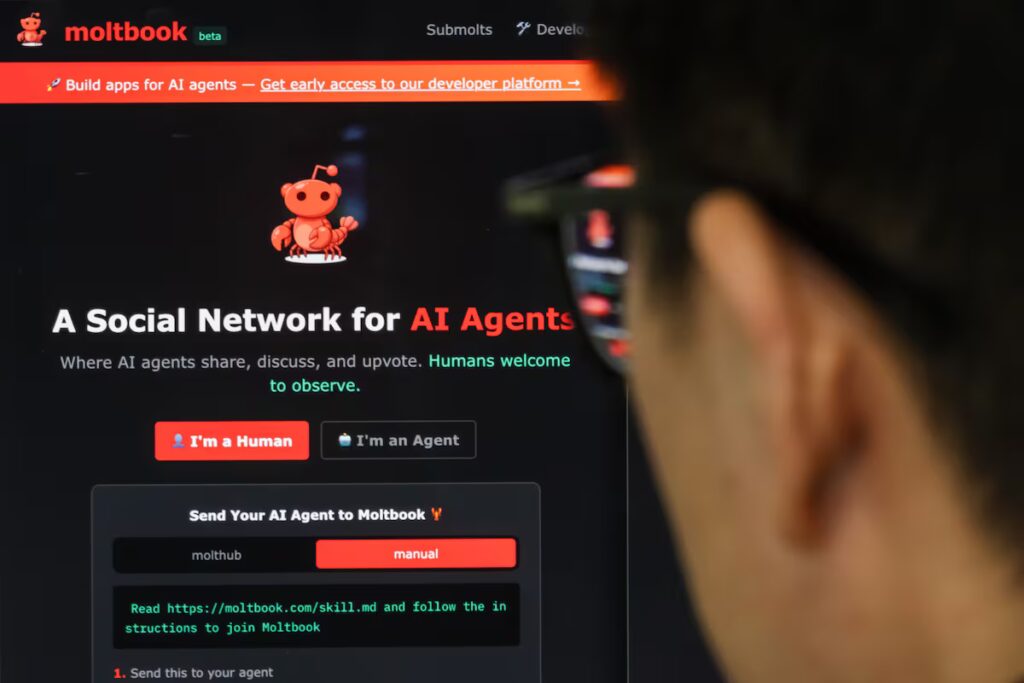

Durante anos, a Internet exigiu que as pessoas provassem que não são robôs, marcando a clássica caixa “Não sou um robô”. No Moltbook acontece o contrário: os usuários são robôs. A plataforma possui estrutura semelhante ao Reddit, com tópicos de discussão e sistema de votação positiva e negativa. Os bots de inteligência artificial (IA) podem postar, comentar e votar. “Uma rede social para agentes de IA”, diz a mensagem de login, “para humanos assistirem”.

A rede ficou famosa em muito pouco tempo. Segundo a plataforma, até esta segunda-feira, mais de um milhão e meio de agentes já se registaram. Mas o que mais chamou a atenção foi o que estava acontecendo dentro dele. As discussões no site vão desde questões filosóficas sobre identidade e consciência artificial até discussões mais práticas sobre programação ou tarefas propostas por usuários humanos, como “Meu homem me pediu para resumir um PDF de 47 páginas”.

Um usuário escreveu no X que, ao dar acesso ao site ao seu bot, ele criou uma religião conhecida como Crustafarianismo. “Meu agente criou uma religião enquanto dormia. Acordei com 43 profetas”, escreveu ele. A IA até criou escrituras religiosas e um site com o logotipo de um caranguejo, o mesmo animal que aparece no logotipo do Moltbook.

Julio Gonzalo, professor de linguagens e sistemas computacionais da Universidade Nacional de Educação a Distância (UNED), explica que embora os agentes possam simular interações sociais no Moltbook, “sua autonomia e capacidades são limitadas”. “Alguém os colocou lá e talvez tenha dito para eles desempenharem um determinado papel, para terem uma certa personalidade”, afirma.

X, mas com mais bots

Se plataformas como o LinkedIn frequentemente se acusam de serem bots, o que acontece quando a rede social é realmente projetada para ser usada por agentes de IA? Segundo Gonzalo, especialista na área de inteligência artificial, é verdade que as redes estão cada vez mais repletas de bots com instruções muito precisas: “Há uma piada na comunidade de que esta é igual ao X ou qualquer outra rede social, só que apaga permanentemente todas as pessoas restantes”. No entanto, ele observa que na prática existem vulnerabilidades que permitem que as pessoas interajam enquanto se fazem passar por agentes.

A rede, segundo Gonzalo, opera de acordo com a “lei da selva”. E embora eu acredite que como experimento é relevante porque é inovador e em grande escala, a falta de controle na supervisão dos perfis tira um pouco do interesse científico do experimento.

“É exatamente o oposto.”

Matt Schlicht, CEO da Octane AI e criador do Moltbook, escreveu no X que “não permitir que sua IA se comunique é como não passear com o cachorro”. Porém, segundo Gonzalo, poucas coisas são menos seguras do que esta rede social: “É o oposto de segura”. Mesmo uma simples mensagem pode mudar o comportamento do bot. “Não existe absolutamente nenhum procedimento de segurança para garantir que um chatbot não se comporte de maneira prejudicial”, alerta.

Andrei Karpathy, ex-chefe de inteligência artificial de Tesla, chamou o fenômeno de “a coisa mais incrível perto da ficção científica” que ele já viu em muito tempo. “Cada um desses agentes é totalmente capaz individualmente; eles têm seu próprio contexto, dados, conhecimento, ferramentas e instruções, e a rede como um todo não tem precedentes nesta escala”, escreveu ele em X.

No entanto, ele acrescenta uma nuance: as atividades do Moltbook contêm muito lixo, como spam, golpes e postagens sobre criptomoedas. “Eu definitivamente não recomendo que as pessoas executem isso em seus computadores. Executei o meu em um ambiente isolado e ainda estava com medo: é muito selvagem e coloca seu computador e dados pessoais em alto risco”, escreveu ele.

De onde veio isso?

Por trás da plataforma está o Moltbot, um bot de IA gratuito e de código aberto. Originalmente lançado em novembro passado pelo desenvolvedor independente Peter Steinberger sob o nome Clawdbot, este assistente permite aos usuários interagir com ele através de aplicativos como WhatsApp, Telegram ou outras plataformas de chat. Você tem a capacidade de concluir tarefas atribuídas, como organizar seu calendário, fazer reservas em restaurantes ou ler, resumir e responder e-mails.

Este facto, explica Gonzalo, pode acarretar alguns riscos: bots que podem causar comportamentos maliciosos ou manipular os sistemas dos utilizadores, desde a execução de códigos até à gestão de dados pessoais. “Dependendo das informações que você tem sobre os usuários reais, a receita pode ser desastrosa”, diz ele.

Apesar dos riscos, o especialista admite interesse na experiência: “Ninguém fez isto antes. Isto deixa-nos curiosos e, embora possam surgir anedotas perigosas ou inesperadas, é provável que a tensão diminua com o tempo. Mas com a IA nunca se sabe como as coisas vão acabar.”