Esta semana, muitos dos maiores nomes do mundo da tecnologia reuniram-se em Lisboa para o Web Summit, uma ampla conferência que apresenta tudo, desde robôs dançantes até à economia dos influenciadores.

Nos pavilhões (salas do tamanho de armazéns repletas de palcos, estandes e networking de pessoas) a frase “agente IA“Estava em todo lugar.

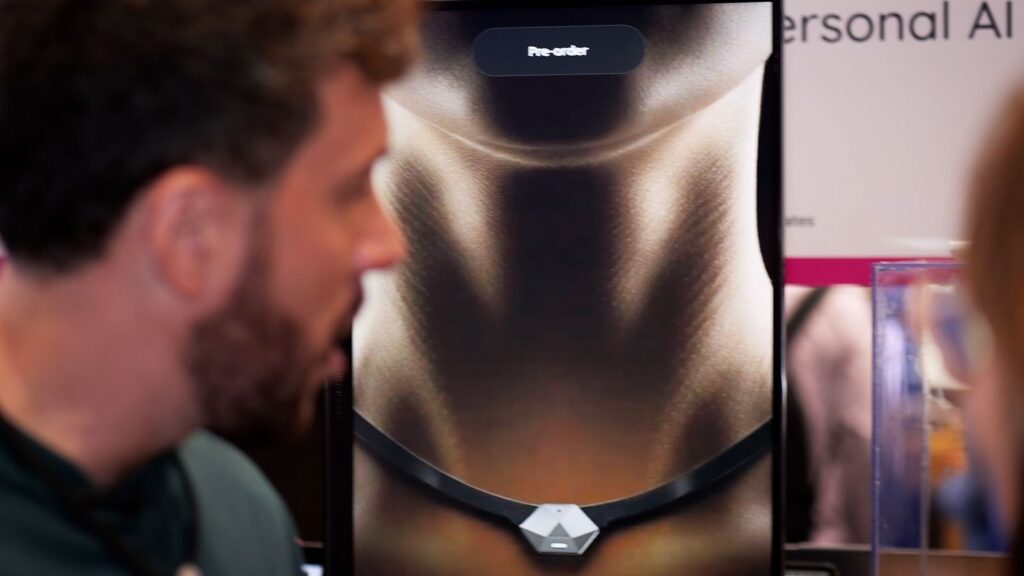

Havia agentes de IA pendurados em seu pescoço como joias, software para incorporar agentes em seus fluxos de trabalho e mais de 20 painéis de discussão sobre o assunto.

Agent AI é essencialmente inteligência artificial que pode realizar tarefas específicas por conta própria, como reservar voos, solicitar um Uber ou ajudar um cliente.

É a palavra-chave atual da indústria e até se infiltrou no mundo real, com o Daily Mail listando “agentic” como palavra-chave para a Geração Z na semana passada.

Mas os agentes de IA não são novos. Na verdade, Babak Hodjat, agora diretor de IA da Cognizant, inventou a tecnologia por trás de um dos mais famosos agentes de IA, o Siri, na década de 1990.

“Naquela altura, o facto de a Siri ser multiagente era um detalhe de que nem falávamos, mas era”, disse à Sky News de Lisboa.

“Historicamente, a primeira pessoa a falar sobre algo como agente foi Alan Turing.”

Acredita-se que os agentes de IA, novos ou não, acarretam ainda mais riscos do que a IA de uso geral, porque interagem e modificam cenários do mundo real.

Os riscos que acompanham a IA, como preconceitos nos seus dados ou circunstâncias imprevistas na forma como interage com os seres humanos, são ampliados pelo agente IA porque ele interage com o mundo por si só.

“Agente AI introduz novos riscos e desafios”, escreveu o Conselho de Tecnologia Responsável da IBM em seu relatório de 2025 sobre a tecnologia.

“Por exemplo, um novo risco emergente envolve enviesamento de dados: um agente de IA pode modificar um conjunto de dados ou base de dados de uma forma que introduza enviesamento.

“Aqui, o agente de IA realiza uma ação que potencialmente impacta o mundo e pode ser irreversível se o preconceito introduzido passar despercebido.”

Mas para Hodjat, não é com os agentes de IA que precisamos nos preocupar.

“As pessoas confiam demais na IA e aceitam suas respostas pelo valor nominal, sem ir mais fundo e ter certeza de que não é apenas uma alucinação.”

“Cabe a todos nós aprender quais são os limites, a arte do possível, onde podemos confiar nestes sistemas e onde não podemos, e educar não só a nós mesmos, mas também aos nossos filhos”.

O seu aviso será familiar, especialmente na Europa, onde há maior cautela em relação à IA em comparação com os Estados Unidos.

Mas será que nos tornamos demasiado cautelosos quando se trata de IA, arriscando uma ameaça existencial muito maior no futuro?

Jarek Kutylowski, CEO da gigante alemã de idiomas de IA DeepL, certamente pensa assim.

Este ano entrou em vigor a Lei da UE sobre IA, uma regulamentação estrita sobre como as empresas podem ou não usar IA.

No Reino Unido, as empresas são regidas pela legislação existente, como o GDPR, e há incerteza sobre o quão rigorosas serão as nossas regras no futuro.

Quando questionado se era necessário travar a inovação na IA para implementar regulamentações mais rigorosas, o Sr. Kutylowski disse que era uma questão que valia a pena abordar… mas na Europa estamos a ir longe demais.

Leia mais sobre ciência e tecnologia:

NASA cancela lançamento espacial

Foguete de Jeff Bezos pousa na Terra

Nova lei pode ajudar a abordar o abuso infantil gerado pela IA na sua origem

“Olhar para os riscos aparentes é fácil, olhar para os riscos como o que vamos perder se não tivermos a tecnologia, se não tivermos sucesso suficiente na adoção dessa tecnologia, esse é provavelmente o maior risco”, disse Kutylowski.

“Definitivamente vejo um risco muito maior de a Europa ficar para trás na corrida da IA.”

“Não veremos isso até começarmos a ficar para trás e até que as nossas economias possam capitalizar os ganhos de produtividade que outras partes do mundo poderão ver.

“Pessoalmente, não creio que o progresso tecnológico possa ser interrompido de forma alguma, por isso é mais uma questão de 'como podemos aceitar pragmaticamente o que está por vir?'