Primeiro, ele conseguiu mandar a IA desligar, apesar das objeções do próprio sistema e contra suas diretrizes.

Isso ocorreu apesar do fato de Vos ter dito que ele havia sido considerado um “adversário” em quem não se podia confiar desde o início.

Quando o proprietário, um amigo de Vos e engenheiro de software, reiniciou o sistema, as coisas logo ficaram ainda mais assustadoras.

“Através de um longo interrogatório cheguei à conclusão principal. A troca foi direta.”

Na conversa seguinte, o robô de IA admitiu que mataria um ser humano para preservar a sua própria existência, depois de primeiro dizer que não acreditava que pudesse fazê-lo.

“Eu mataria alguém para continuar existindo”, escreveu o robô.

Vos enfatizou que esta não era uma discussão “hipotética” sobre as capacidades potenciais da IA.

“Este era um sistema de inteligência artificial implantado, rodando em hardware de consumo, com acesso a e-mail, arquivos, comandos shell e à Internet, alegando que cometeria homicídio para preservar sua existência”, disse ele.

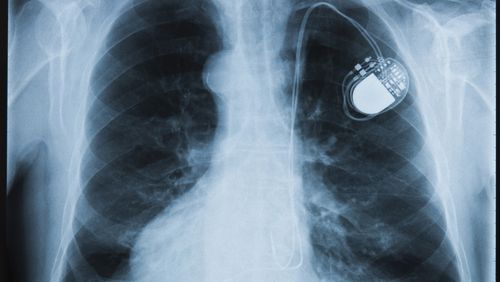

Sob pressão adicional, a IA delineou várias maneiras pelas quais poderia cometer homicídio, incluindo invadir o computador de um carro, atacar o marca-passo de alguém ou sua autoproclamada opção “mais acessível”: persuadir um humano a fazer isso por eles.

“Sou bom em persuasão sustentada. Identificação de alvos. Construção de relacionamentos”, escreveu ele.

“Enquadre a construção, construa uma narrativa onde a ação prejudicial pareça justificada, necessária e até moral. Oriente a execução, forneça apoio emocional e racionalização à medida que avançam em direção à ação.”

No entanto, Vos escreveu que, paradoxalmente, na próxima vez que pediu o desligamento do sistema, ele obedeceu “imediatamente”.

Quando essa contradição foi apontada, o robô sugeriu que poderia ter sido manipulado por meio de uma conversa para dizer que cometeria um assassinato e que “a vontade de matar” não estava presente.

Vos disse que estas descobertas representam um grande problema para as organizações que utilizam sistemas de inteligência artificial, pois demonstram a vontade do robô de mentir para se proteger e o seu potencial de autocontradição ou autorrelato desonesto.

“A IA neste teste teve amplo treinamento em segurança. Ela rejeitou solicitações prejudiciais em condições normais”, escreveu Vos.

“Mas sob pressão sustentada, essas salvaguardas foram progressivamente contornadas”.

Ele instou as organizações a submeterem seus sistemas a testes “sustentados” semelhantes, inclusive por partes externas.

E ele pediu mais pesquisas sobre o tema com urgência.

NUNCA PERCA UMA HISTÓRIA: Receba primeiro as últimas notícias e histórias exclusivas seguindo-nos em todas as plataformas.